Cảnh giác trước cuộc gọi giả danh công an để đánh cắp thông tin khuôn mặt

Cảnh giác với cuộc gọi lạ

Mới đây, Đoàn thanh niên Công an TP HCM đã ra thông báo cảnh báo về một thủ đoạn lừa đảo đánh cắp thông tin cá nhân mới.

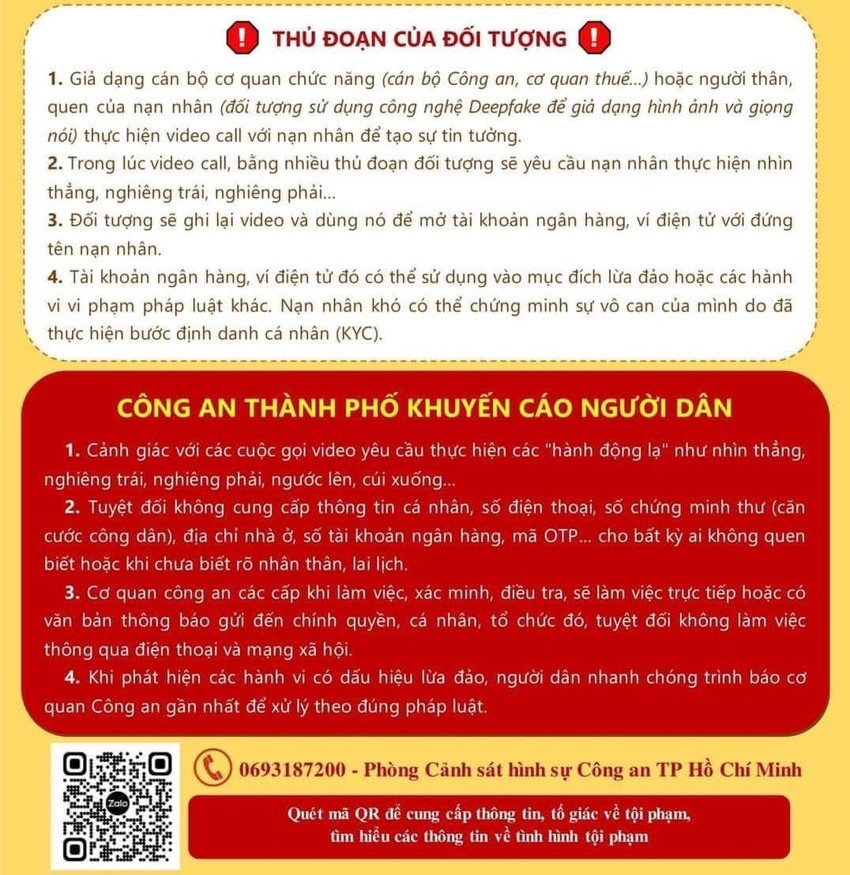

Theo đó, các đối tượng lừa đảo sẽ giả dạng cán bộ công an, thuế vụ, các cơ quan chức năng khác hoặc dùng công nghệ Deepfake để giả hình ảnh và giọng nói người thân, quen của nạn nhân để thực hiện cuộc gọi video nhằm tạo sự tin tưởng.

Deepfake là công nghệ mô phỏng hình ảnh khuôn mặt con người ứng dụng trí tuệ nhân tạo, được nhiều đối tượng sử dụng cho mục đích lừa đảo, đặc biệt trong thời gian gần đây đó chính là những cuộc gọi video.

Trong quá trình gọi video, các đối tượng lừa đảo bằng nhiều thủ đoạn sẽ làm mọi cách để yêu cầu nạn nhân thực hiện nhìn thẳng, nghiêng trái, nghiêng phải… Sau khi thu được các thông tin qua hình ảnh, đối tượng lừa đảo sẽ dùng để vượt qua thủ tục định danh cá nhân rồi mở tài khoản ngân hàng, ví điện tử đứng tên nạn nhân.

Các tài khoản ngân hàng, ví điện tử với định danh của nạn nhân sau đó có thể được sử dụng vào mục đích lừa đảo hoặc các hành vi phạm pháp luật khác. Nạn nhân có thể trở thành người liên quan đến các vụ việc này do đã thực hiện bước định danh cá nhân.

Trước thủ đoạn lừa đảo mới này, Công an TP HCM khuyến cáo, người dân nên cảnh giác với các cuộc gọi video yêu cầu thực hiện các hành động lạ như: Nhìn thẳng, nghiêng trái, nghiêng phải, ngước lên, cúi xuống…

Bên cạnh đó, tuyệt đối không cung cấp thông tin cá nhân, số điện thoại, số chứng minh thư (căn cước công dân), địa chỉ nhà ở, số tài khoản ngân hàng, mã OTP… cho bất kỳ ai không quen biết hoặc khi chưa biết rõ nhân thân, lai lịch.

Cơ quan công an các cấp khi làm việc, xác minh, điều tra thì tuyệt đối không thông qua điện thoại hay mạng xã hội, mà cần trao đổi trực tiếp hoặc có văn bản thông báo gửi đến chính quyền, cá nhân, tổ chức.

Khi gặp các trường hợp nghi ngờ, người dân nhanh chóng trình báo cơ quan công an gần nhất để xử lý theo đúng pháp luật.

Trước đó trên mạng xã hội Facebook, một chủ tài khoản tên Đ.H.V cũng nhận được cuộc gọi video từ Zalo của một người giả danh công an, yêu cầu xác minh danh tính do có liên quan đến một khoản tiền từ thiện. Khi nghe cuộc gọi, đối tượng giả danh này yêu cầu chị Đ.H.V nhìn thẳng, nghiêng trái nghiêng phải như quy trình của việc định danh cá nhân qua quét khuôn mặt.

Đánh cắp thông tin khuôn mặt

Việc bị đánh cắp thông tin khuôn mặt đang là một vấn đề nóng trong thời điểm hiện tại bởi có nhiều thủ đoạn lừa đảo đang lợi dụng thông tin này đã chiếm đoạt tài sản của nạn nhân. Đặc biệt với công nghệ Deepfake đang phát triển và trí tuệ nhân tạo ngày một thông minh.

Theo ông Ngô Minh Hiếu - Chuyên gia an ninh mạng Trung tâm Giám sát An toàn không gian mạng Quốc gia cho biết, lừa đảo Deepfake được tội phạm quốc tế đã và đang áp dụng từ hai ba năm qua. Việc tội phạm trong mạng trong nước bắt đầu biết nhiều hơn cách làm, đánh cắp video, hình ảnh, rồi cắt ghép sau đó dùng những công cụ để tạo Deepfake thì lúc đó có thể sẽ tạo ra "một làn sóng lừa đảo thế hệ 4.0".

Làn sóng lừa đảo này sẽ khiến người cẩn thận, lâu nay rất khó bị lừa cũng có thể trở thành nạn nhân. Đặc biệt đối tượng trung niên trở lên sẽ dễ bị lừa nhất vì họ thiếu kiến thức về an toàn thông tin, hiểu biết về công nghệ và khó nhận biết kiểu lừa này nếu không có được sự chia sẻ hướng dẫn an toàn trên không gian mạng.

Ông Hiếu cũng nêu một số dấu hiệu lừa đảo bằng Deepfake qua video như khuôn mặt thiếu tính cảm xúc và khá "trơ" khi nói, tư thế lúng túng, không tự nhiên. Hoặc có thể nhận biết từ các yếu tố khác như âm thanh, tín hiệu, ánh sáng, màu da… bất thường của người trong video.

Và cuối cùng có thể xảy ra tình huống mà tài khoản chuyển tiền không phải của người đang thực hiện cuộc gọi. Các đối tượng lừa đảo thường sẽ ngắt cuộc gọi giữa chừng với lý do sóng yếu, mất sóng để lừa nạn nhân.

Theo chuyên gia Ngô Minh Hiếu, để phòng tránh việc mình có thể trở thành nạn nhân của thủ đoạn lừa đảo mới, người dùng nên tỉnh táo khi có một ai đó trên mạng xã hội trong danh sách bạn bè tự nhiên hỏi mượn tiền hay gửi link lạ thì không nên vội, mà hãy bình tĩnh, kiểm chứng và nên xác thực mọi thứ.

Người dùng cũng nên chủ động xác thực bằng cách gọi điện thoại trực tiếp hoặc Facetime ít nhất trên 1 phút, sau đó đặt ra những câu hỏi cá nhân mà chỉ có mình và người thân quen mới biết. Deepfake sẽ không thể giả được một cuộc trò chuyện thật sự trong thời gian thực mà có tính chuẩn xác cao do cảm xúc hay biểu cảm của AI hay Deepfake tính đến thời điểm này vẫn không thể bắt chước được như người thật tính.

Bên cạnh đó, ông Hiếu cảnh báo người dùng nên hạn chế chia sẻ thông tin, clip cá nhân và luôn bảo mật tài khoản mạng xã hội, email bằng mật khẩu có độ khó cao. Nếu cẩn thận, có thể làm méo âm thanh trước khi chia sẻ trên mạng xã hội, tránh trường hợp kẻ gian dùng âm thanh để cắt ghép, chỉnh sửa rồi dùng với mục đích xấu. Ngoài ra cần nâng cao khả năng nhận biết các thủ đoạn lừa đảo đang ngày càng tinh vi hơn như hiện nay.